Lưu Trữ Và Tính Toán: Nhu Cầu Song Song Cho Quy Trình Làm Việc AI

Lưu Trữ Và Tính Toán: Nhu Cầu Song Song Cho Quy Trình Làm Việc AI

Ổ cứng và SSD cùng với GPU, CPU, HBM và DRAM trở thành những thành phần quan trọng trong các ứng dụng AI.

Việc áp dụng các ứng dụng trí tuệ nhân tạo (AI) tiếp tục phát triển trên toàn thế giới. Đồng thời, khả năng của các giải pháp CNTT cho phép AI đang tăng tốc nhanh chóng. Sự đổi mới chưa từng có theo sau.

Hiện tại, bộ xử lý (logic) nhận được nhiều sự chú ý nhất từ các nhà lãnh đạo doanh nghiệp và nhà đầu tư vì những đóng góp của nó cho AI. Chắc chắn, bộ xử lý là yếu tố thiết yếu đối với AI và điện toán hiệu suất cao. Nhưng thành công của AI không chỉ phụ thuộc vào hiệu suất tính toán và tốc độ cao. Quan trọng không kém, các ứng dụng AI cũng dựa vào lưu trữ dữ liệu, cung cấp kho lưu trữ dữ liệu thô ban đầu, cho phép kiểm tra điểm để xây dựng lòng tin vào quy trình làm việc của AI và lưu trữ các suy luận và kết quả phân tích AI.

Bất kỳ triển khai AI thành công nào cũng cần có sự kết hợp giữa tài nguyên tính toán và lưu trữ dữ liệu.

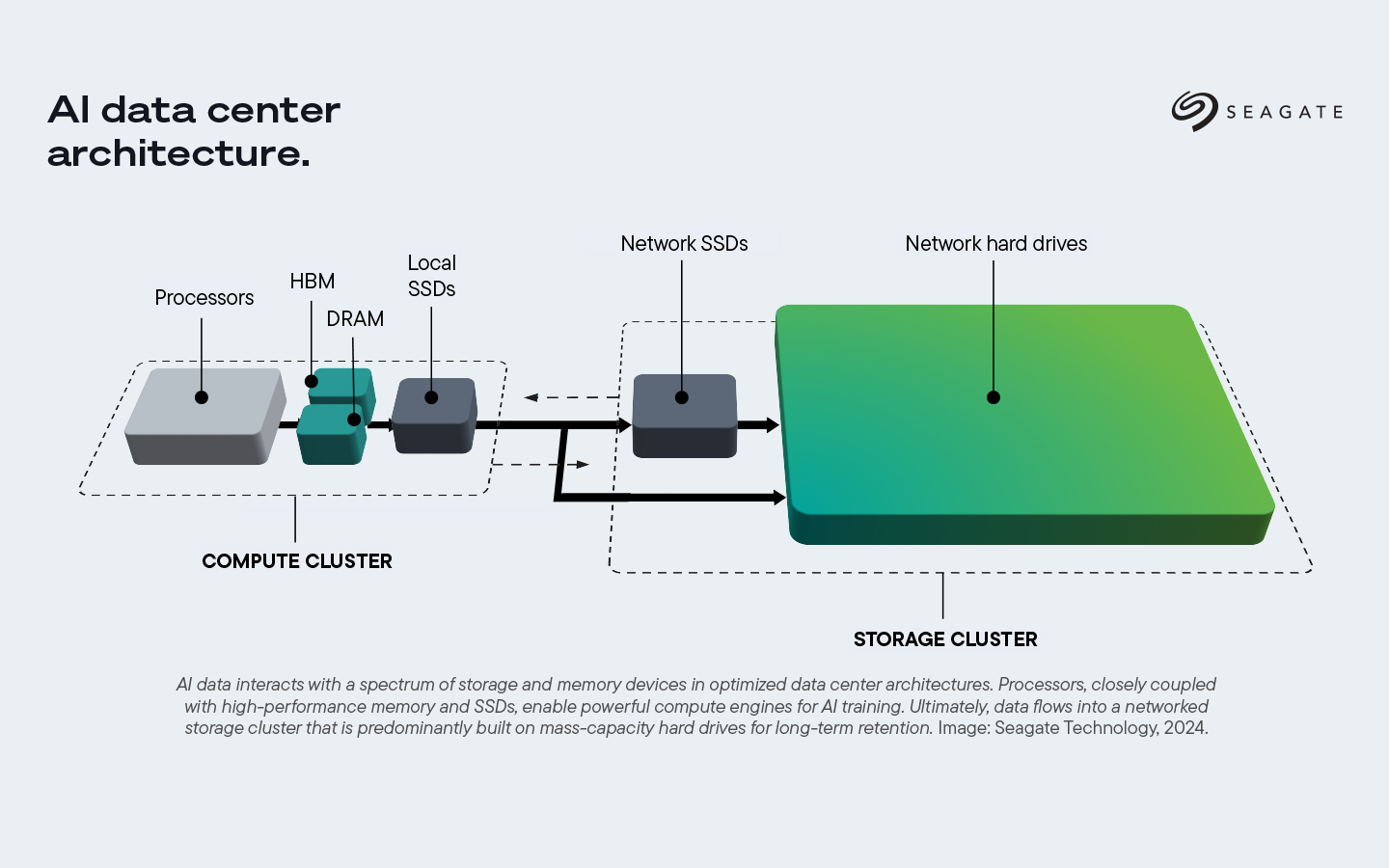

Khi các trung tâm dữ liệu lớn mở rộng khả năng AI của mình, chúng ta sẽ thấy rõ hơn cách các ứng dụng AI không chỉ dựa vào khía cạnh tính toán của kiến trúc trung tâm dữ liệu AI. Cụm tính toán bao gồm các bộ xử lý có bộ nhớ băng thông cao, hiệu suất cao (HBM), bộ nhớ truy cập ngẫu nhiên động (DRAM) và ổ đĩa thể rắn cục bộ (SSD) hoạt động nhanh — xây dựng nên công cụ mạnh mẽ để đào tạo AI. Các thành phần cụm tính toán là cục bộ, thường nằm ngay cạnh nhau, vì bất kỳ khoảng cách nào được thêm vào cũng có thể gây ra các vấn đề về độ trễ và hiệu suất.

Các ứng dụng AI cũng phụ thuộc vào cụm lưu trữ, bao gồm ổ cứng mạng dung lượng cao và ổ SSD mạng (có nghĩa là có dung lượng cao hơn so với ổ SSD cục bộ hiệu suất cao hơn trong cụm tính toán). Cụm lưu trữ được kết nối mạng (phân tán) vì ít quan tâm đến tốc độ hiệu suất lưu trữ ở quy mô lớn. Khoảng cách giữa các thành phần là một yếu tố nhỏ hơn trong phương trình độ trễ tổng thể của nó, so với cụm tính toán, nơi độ trễ dự kiến có thể lên đến nano giây. Dữ liệu cuối cùng chảy đến cụm lưu trữ, bao gồm chủ yếu là ổ cứng dung lượng lớn để lưu giữ lâu dài.

Bài viết này xem xét cách tính toán và lưu trữ hoạt động cùng nhau trong nhiều giai đoạn của quy trình làm việc AI thông thường.

Hiệu suất và khả năng mở rộng cho AI.

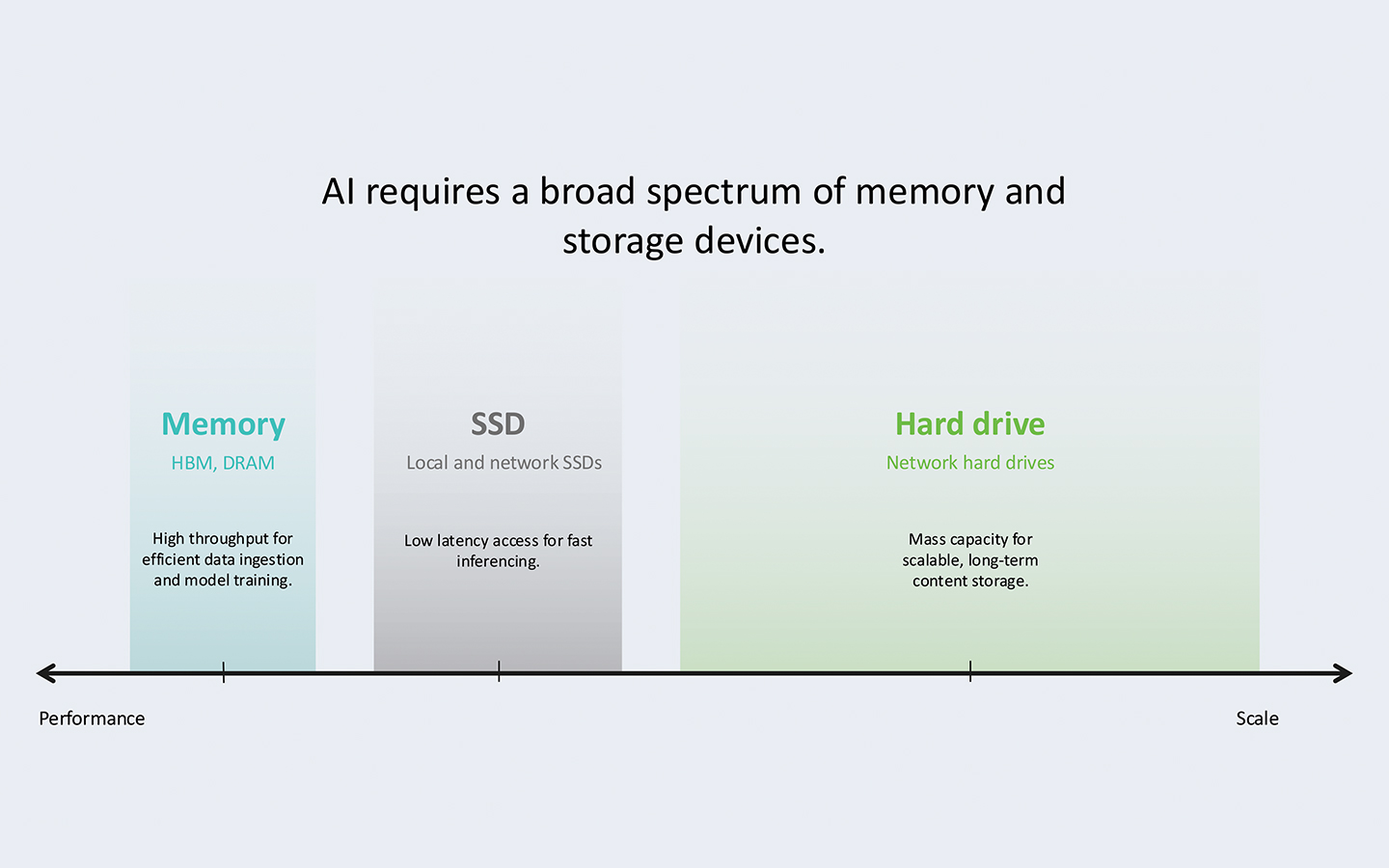

Một số công nghệ trong quy trình làm việc AI có hiệu suất cao hơn và một số có khả năng mở rộng hơn, nhưng mỗi công nghệ đều là một phần không thể thiếu của quy trình. Bộ nhớ trên thiết bị có hiệu suất cao, thường bao gồm HBM hoặc DRAM được gắn vào bộ xử lý — bộ xử lý đồ họa (GPU) và bộ xử lý trung tâm (CPU) hoặc bộ xử lý dữ liệu (DPU). DPU là các công cụ chức năng chuyển tải, được gắn vào CPU, giúp thực hiện các tác vụ cụ thể. Một số kiến trúc sử dụng chúng, trong khi một số khác thì không. Thông lượng cao của bộ nhớ cho phép thu thập dữ liệu hiệu quả và các khía cạnh đào tạo mô hình của AI.

Độ trễ thấp và dung lượng đủ của SSD cho phép suy luận nhanh và truy cập thường xuyên vào nội dung được lưu trữ. Trong kiến trúc trung tâm dữ liệu AI, SSD cục bộ có hiệu suất nhanh được bao gồm trong cụm máy tính, gần bộ xử lý và bộ nhớ. SSD cục bộ thường chạy bộ nhớ ô ba cấp và cũng có độ bền cao, nhưng chúng thường đắt hơn SSD mạng và không có cùng dung lượng cao.

SSD mạng, với dung lượng lưu trữ dữ liệu cao hơn so với SSD cục bộ, được bao gồm trong cụm lưu trữ, với các trách nhiệm cụ thể khác trong toàn bộ quy trình làm việc của ứng dụng AI. Tốc độ hiệu suất của chúng không bằng tốc độ của SSD cục bộ. SSD mạng kém bền hơn về số lần ghi ổ đĩa mỗi ngày, nhưng chúng bù đắp bằng dung lượng lớn hơn.

Ổ cứng mạng, cũng là một phần của cụm lưu trữ của kiến trúc trung tâm dữ liệu AI, là thiết bị CNTT có khả năng mở rộng và hiệu quả nhất trong quy trình làm việc AI. Các thiết bị này có tốc độ truy cập tương đối vừa phải, nhưng dung lượng rất cao, hoàn hảo cho các trường hợp không yêu cầu truy cập thường xuyên nhanh chóng.

Vòng lặp vô hạn của AI.

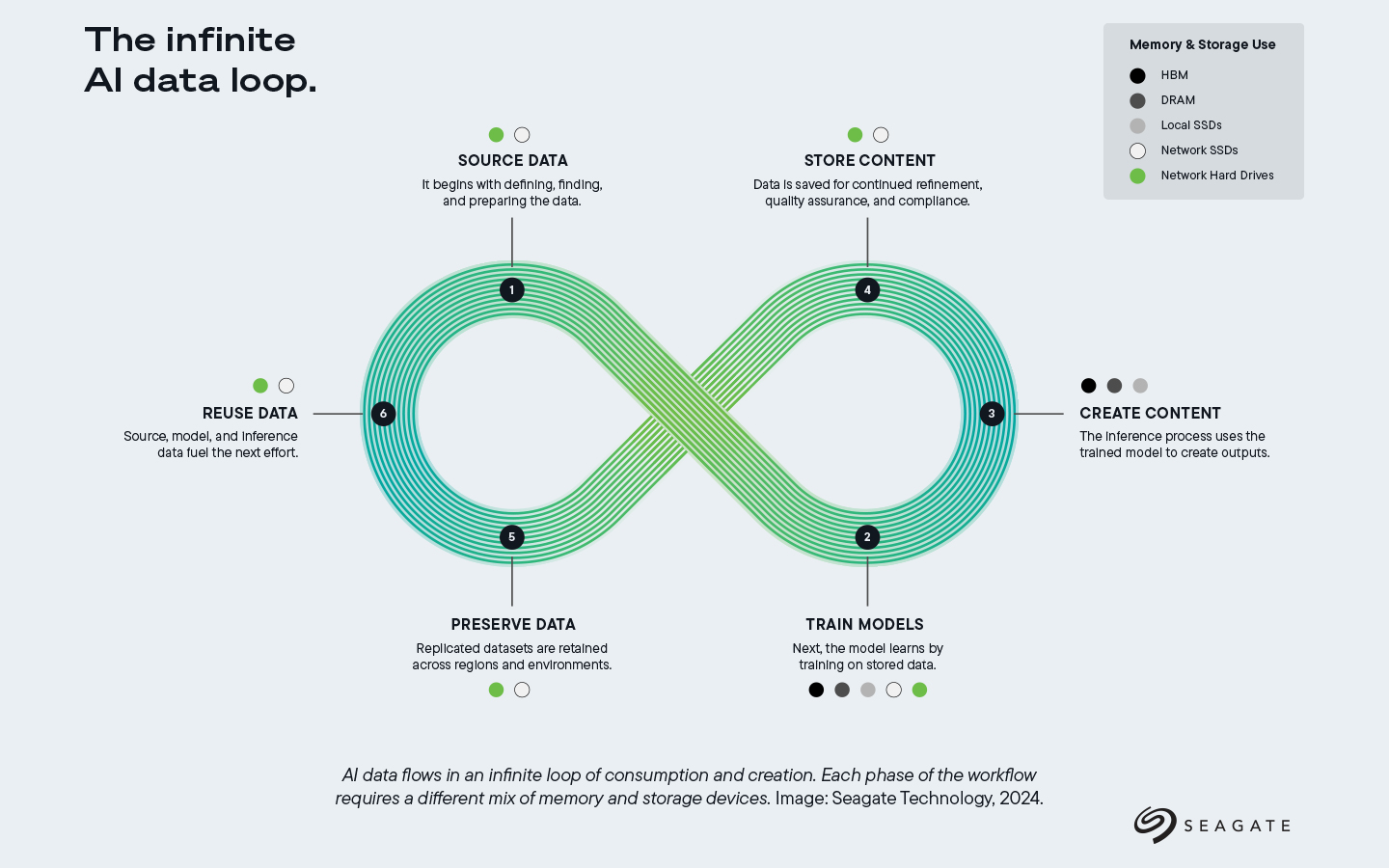

Quy trình làm việc AI hoạt động trong một vòng lặp vô hạn của việc tiêu thụ và tạo ra, không chỉ yêu cầu bộ xử lý và bộ nhớ hỗ trợ tính toán mà còn cả các thành phần lưu trữ. Các bước liên quan của quy trình làm việc AI bao gồm dữ liệu nguồn, đào tạo mô hình, tạo nội dung, lưu trữ nội dung, bảo quản dữ liệu và tái sử dụng dữ liệu. Hãy cùng xem xét vai trò của tính toán và lưu trữ trong các giai đoạn này.

Bước 1: Nguồn dữ liệu.

Giai đoạn tìm nguồn dữ liệu bao gồm việc xác định, khám phá và chuẩn bị dữ liệu để phân tích AI.

Tính toán: GPU đóng vai trò nền tảng trong giai đoạn tìm nguồn dữ liệu bằng cách thúc đẩy quá trình tiền xử lý và chuyển đổi dữ liệu tốc độ cao. Chúng bổ sung cho CPU, chạy các phép tính lặp đi lặp lại song song trong khi ứng dụng chính chạy trên CPU. CPU hoạt động như một đơn vị chính, quản lý nhiều tác vụ tính toán mục đích chung khi GPU thực hiện một tập hợp nhỏ hơn các tác vụ chuyên biệt hơn.

Lưu trữ: Trong giai đoạn tìm nguồn dữ liệu, cả SSD mạng và ổ cứng mạng đều được sử dụng để lưu trữ lượng dữ liệu khổng lồ cần thiết để tạo ra thứ gì đó mới. SSD mạng hoạt động như một tầng dữ liệu có thể truy cập ngay lập tức, mang lại hiệu suất nhanh hơn. Ổ cứng mạng cung cấp dung lượng rộng rãi, dày đặc, có thể mở rộng và cũng cung cấp dữ liệu thô với khả năng lưu giữ và bảo vệ dữ liệu lâu dài.

Bước 2: Đào tạo các mô hình.

Trong bước đào tạo mô hình, mô hình học từ dữ liệu được lưu trữ. Đào tạo là một quá trình thử và sai, trong đó mô hình hội tụ và được bảo vệ bằng các điểm kiểm tra. Đào tạo yêu cầu truy cập dữ liệu tốc độ cao.

Tính toán: GPU rất quan trọng trong giai đoạn đào tạo mô hình, khi khả năng xử lý song song của chúng cho phép chúng xử lý khối lượng tính toán khổng lồ liên quan đến học sâu. Đào tạo AI bao gồm hàng nghìn phép nhân ma trận, mà GPU xử lý đồng thời, giúp tăng tốc quá trình và giúp đào tạo các mô hình phức tạp với hàng tỷ tham số. CPU hoạt động cùng với GPU, điều phối luồng dữ liệu giữa bộ nhớ và tài nguyên tính toán. CPU quản lý các tác vụ như chuẩn bị hàng loạt và quản lý hàng đợi, do đó dữ liệu phù hợp được đưa vào GPU vào đúng thời điểm. Chúng cũng xử lý việc tối ưu hóa các siêu tham số của mô hình, thực hiện các phép tính có thể không yêu cầu sức mạnh xử lý song song của GPU.

Trong đào tạo mô hình, HBM và DRAM rất cần thiết để truy cập dữ liệu nhanh, giữ các tập dữ liệu đang hoạt động ở gần bộ xử lý. HBM, thường được tích hợp vào GPU, tăng đáng kể tốc độ xử lý dữ liệu bằng cách giữ dữ liệu được sử dụng thường xuyên nhất có thể truy cập được vào GPU trong quá trình đào tạo.

SSD cục bộ đóng vai trò là bộ lưu trữ truy cập nhanh cho các tập dữ liệu được sử dụng trong giai đoạn này. Chúng lưu trữ kết quả đào tạo trung gian và cho phép truy xuất nhanh các tập dữ liệu lớn. Chúng đặc biệt hữu ích cho các mô hình đào tạo yêu cầu truy cập nhanh vào lượng dữ liệu lớn, chẳng hạn như các mô hình nhận dạng hình ảnh liên quan đến hàng triệu hình ảnh.

Lưu trữ: Ổ cứng lưu trữ dữ liệu khổng lồ cần thiết để đào tạo các mô hình AI một cách tiết kiệm. Ngoài việc cung cấp dung lượng có thể mở rộng cần thiết, ổ cứng còn giúp duy trì tính toàn vẹn của dữ liệu — lưu trữ và bảo vệ các phiên bản sao chép của nội dung đã tạo. Ổ cứng tiết kiệm chi phí hơn so với các tùy chọn lưu trữ khác, cung cấp khả năng lưu trữ đáng tin cậy trong thời gian dài, đồng thời bảo quản và quản lý hiệu quả các tập dữ liệu lớn.

Trong số những thứ khác, ổ cứng mạng và SSD mạng lưu trữ các điểm kiểm tra để bảo vệ và tinh chỉnh quá trình đào tạo mô hình. Điểm kiểm tra là các ảnh chụp nhanh đã lưu về trạng thái của mô hình tại những thời điểm cụ thể trong quá trình đào tạo, điều chỉnh và thích ứng. Những ảnh chụp nhanh này có thể được gọi sau đó để chứng minh quyền sở hữu trí tuệ hoặc cho thấy cách thuật toán đi đến kết luận của mình. Khi SSD được sử dụng trong điểm kiểm tra, các điểm kiểm tra được ghi ở một khoảng thời gian nhanh (tức là mỗi phút) do khả năng truy cập có độ trễ thấp của chúng. Tuy nhiên, dữ liệu đó thường bị ghi đè sau một khoảng thời gian ngắn do dung lượng nhỏ của chúng so với ổ cứng. Ngược lại, các điểm kiểm tra ổ cứng đã lưu thường được ghi ở một khoảng thời gian chậm hơn (ví dụ: cứ năm phút một lần), nhưng có thể được lưu giữ gần như vĩnh viễn do dung lượng có thể mở rộng của ổ cứng.

Bước 3: Tạo nội dung.

Giai đoạn tạo nội dung bao gồm quá trình suy luận sử dụng mô hình đã đào tạo để tạo ra đầu ra.

Tính toán: Trong quá trình tạo nội dung, GPU thực hiện các tác vụ suy luận AI, áp dụng mô hình đã được đào tạo vào các dữ liệu đầu vào mới. Tính song song này cho phép GPU thực hiện nhiều suy luận cùng lúc, khiến chúng trở nên không thể thiếu đối với các ứng dụng thời gian thực như tạo video hoặc hệ thống AI đàm thoại. Trong khi GPU thống trị các tác vụ tính toán trong quá trình tạo nội dung, CPU đóng vai trò quan trọng trong việc quản lý logic điều khiển và thực hiện bất kỳ hoạt động nào yêu cầu xử lý tuần tự. Điều này bao gồm tạo tập lệnh, xử lý dữ liệu đầu vào của người dùng và chạy các tác vụ nền có mức độ ưu tiên thấp hơn không cần thông lượng cao của GPU.

Bước tạo nội dung sử dụng HBM và DRAM. Bộ nhớ đóng vai trò quan trọng trong việc truy cập dữ liệu theo thời gian thực, lưu trữ tạm thời kết quả suy luận của AI và đưa chúng trở lại mô hình để tinh chỉnh thêm. DRAM dung lượng cao cho phép lặp lại nhiều lần việc tạo nội dung mà không làm chậm quy trình làm việc, đặc biệt là trong các ứng dụng như tạo video hoặc xử lý hình ảnh theo thời gian thực.

Trong quá trình tạo nội dung, SSD cục bộ cung cấp tốc độ đọc/ghi nhanh cần thiết cho quá trình xử lý theo thời gian thực. Cho dù AI đang tạo hình ảnh, video hay văn bản mới, SSD cho phép hệ thống xử lý các hoạt động I/O tốc độ cao thường xuyên mà không bị tắc nghẽn, đảm bảo nội dung được tạo ra nhanh chóng.

Lưu trữ: Các yếu tố lưu trữ chính của bước tạo là HBM, DRAM và SSD cục bộ.

Bước 4: Lưu trữ nội dung.

Trong giai đoạn lưu trữ nội dung , dữ liệu mới tạo được lưu lại để tiếp tục tinh chỉnh, đảm bảo chất lượng và tuân thủ.

Tính toán: Mặc dù không liên quan trực tiếp đến lưu trữ dài hạn, GPU và CPU có thể hỗ trợ nén hoặc mã hóa dữ liệu khi dữ liệu đang được chuẩn bị để lưu trữ. Khả năng xử lý nhanh khối lượng dữ liệu lớn của chúng có nghĩa là nội dung đã sẵn sàng để lưu trữ mà không bị chậm trễ. Bộ nhớ được sử dụng làm bộ đệm tạm thời trước khi dữ liệu được chuyển vào bộ lưu trữ dài hạn. DRAM tăng tốc các hoạt động ghi, lưu nội dung do AI tạo ra một cách nhanh chóng và hiệu quả. Điều này đặc biệt quan trọng trong các ứng dụng AI thời gian thực, nơi sự chậm trễ trong việc lưu trữ dữ liệu có thể dẫn đến tình trạng tắc nghẽn.

Lưu trữ: Giai đoạn lưu trữ nội dung phụ thuộc vào cả ổ SSD mạng và ổ cứng mạng, lưu dữ liệu để tiếp tục tinh chỉnh, đảm bảo chất lượng và tuân thủ. SSD mạng cung cấp một tầng dữ liệu phù hợp với tốc độ và được sử dụng để lưu trữ nội dung do AI tạo ra trong thời gian ngắn, tốc độ cao. Do dung lượng thấp hơn so với ổ cứng, SSD thường lưu trữ nội dung được truy cập thường xuyên hoặc nội dung phải có sẵn ngay để chỉnh sửa và tinh chỉnh.

Quá trình lặp lại tạo ra dữ liệu mới, được xác thực cần lưu trữ. Dữ liệu này được lưu để tiếp tục tinh chỉnh, đảm bảo chất lượng và tuân thủ. Ổ cứng lưu trữ và bảo vệ các phiên bản sao chép của nội dung đã tạo và cung cấp dung lượng quan trọng để lưu trữ nội dung được tạo trong quá trình AI. Chúng đặc biệt phù hợp cho mục đích này vì chúng cung cấp dung lượng lưu trữ cao với chi phí tương đối thấp so với các tùy chọn lưu trữ khác như SSD.

Bước 5: Lưu giữ dữ liệu.

Trong giai đoạn bảo quản dữ liệu , các tập dữ liệu được sao chép được lưu giữ trên khắp các vùng và môi trường. Tài nguyên lưu trữ thường được sử dụng trong giai đoạn này.

Lưu trữ: Dữ liệu được lưu trữ là xương sống của AI đáng tin cậy , cho phép các nhà khoa học dữ liệu đảm bảo các mô hình hoạt động như mong đợi. SSD mạng được sử dụng như một miếng đệm hiệu suất để kết nối ổ cứng với lớp SSD cục bộ và giúp dữ liệu di chuyển trong hệ sinh thái.

Ổ cứng là công cụ chính cho phép dữ liệu cần lưu trữ và bảo vệ dữ liệu dài hạn hơn. Chúng giúp duy trì kết quả của việc tạo nội dung AI, lưu trữ an toàn nội dung được tạo ra, để có thể truy cập khi cần. Chúng cũng cung cấp khả năng mở rộng cần thiết để xử lý khối lượng dữ liệu ngày càng tăng một cách hiệu quả.

Bước 6: Tái sử dụng dữ liệu.

Cuối cùng, trong giai đoạn tái sử dụng dữ liệu , dữ liệu nguồn, dữ liệu đào tạo và dữ liệu suy luận được áp dụng cho lần lặp tiếp theo của quy trình làm việc.

Tính toán: GPU đóng vai trò quan trọng trong giai đoạn tái sử dụng dữ liệu bằng cách chạy lại các mô hình trên các tập dữ liệu đã lưu trữ để có suy luận mới hoặc đào tạo bổ sung, cho phép chu kỳ dữ liệu AI bắt đầu lại. Khả năng thực hiện các phép tính song song trên các tập dữ liệu lớn cho phép các hệ thống AI liên tục cải thiện độ chính xác của mô hình với thời gian đầu tư tối thiểu. CPU truy vấn và truy xuất dữ liệu đã lưu trữ để tái sử dụng. Chúng lọc và xử lý dữ liệu lịch sử một cách hiệu quả, đưa các phần có liên quan trở lại các mô hình đào tạo. Trong các hệ thống AI quy mô lớn, CPU thường thực hiện các tác vụ này trong khi quản lý các tương tác giữa các hệ thống lưu trữ và cụm tính toán.

Khi dữ liệu lịch sử được truy xuất để tái sử dụng trong một lần lặp lại khác của phân tích mô hình AI, bộ nhớ đảm bảo truy cập nhanh vào các tập dữ liệu lớn. HBM cho phép tải nhanh các tập dữ liệu vào bộ nhớ GPU, nơi chúng có thể được sử dụng ngay lập tức để đào tạo lại hoặc suy luận theo thời gian thực.

Lưu trữ: Nội dung đầu ra phản hồi lại mô hình, cải thiện độ chính xác và cho phép các mô hình mới. Ổ cứng mạng và SSD hỗ trợ tạo dữ liệu AI phân tán theo địa lý. Các tập dữ liệu thô và kết quả trở thành nguồn cho các quy trình làm việc mới. SSD tăng tốc việc truy xuất dữ liệu đã lưu trữ trước đó. Khả năng truy cập có độ trễ thấp của chúng thúc đẩy việc tích hợp lại nhanh chóng dữ liệu này vào quy trình làm việc AI, giảm thời gian chờ và tăng hiệu quả chung của hệ thống. Ổ cứng đáp ứng các yêu cầu lưu trữ dung lượng lớn của giai đoạn tái sử dụng dữ liệu AI, cho phép triển khai lần lặp lại tiếp theo của mô hình với chi phí hợp lý.

Lưu trữ là xương sống của AI.

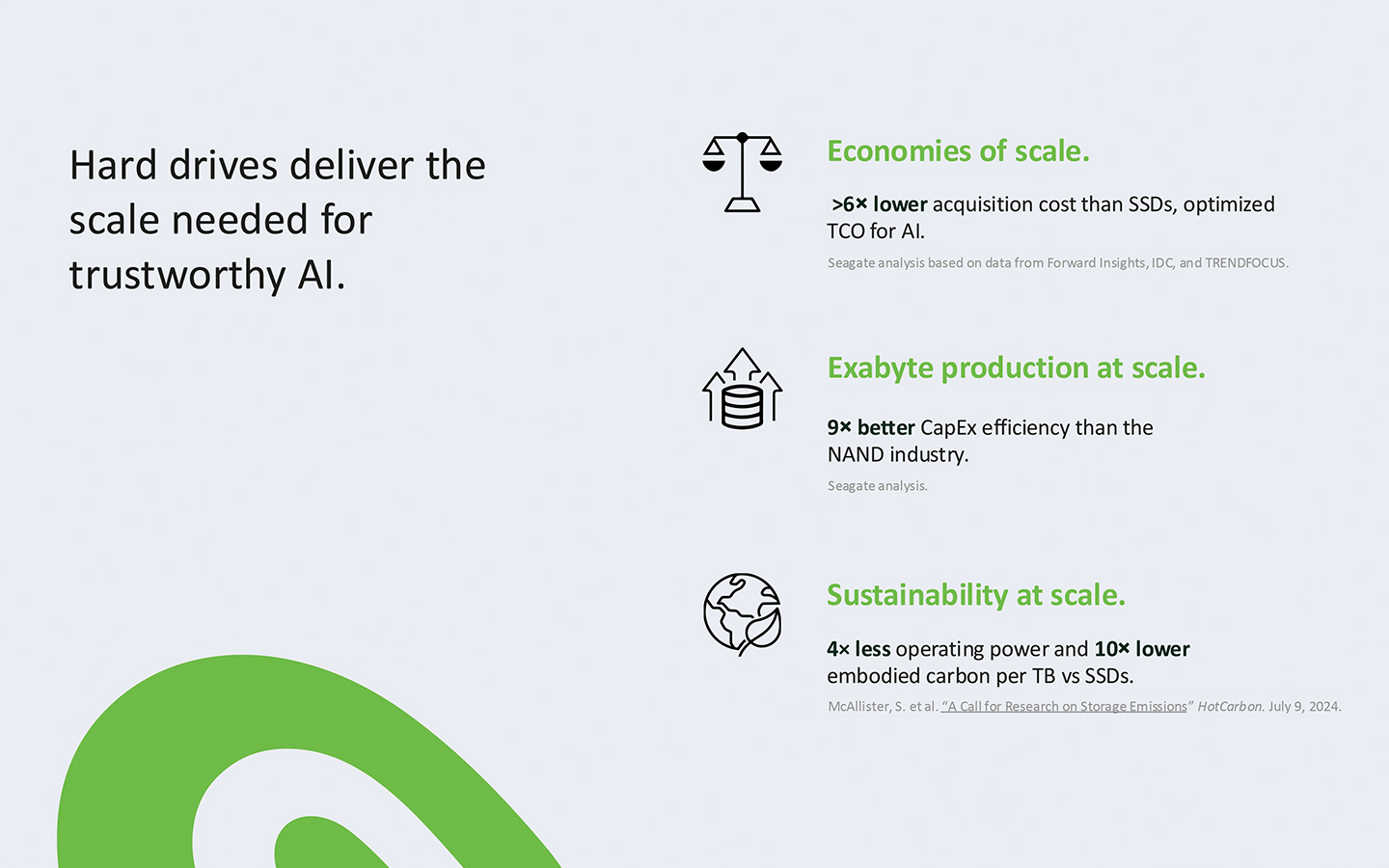

Như chúng ta đã thấy, quy trình làm việc AI đòi hỏi bộ xử lý hiệu suất cao cũng như các giải pháp lưu trữ dữ liệu. Bộ nhớ trên thiết bị và SSD có vị trí của chúng trong các ứng dụng AI do hiệu suất tốc độ cao, cho phép suy luận nhanh. Nhưng chúng tôi muốn coi ổ cứng là xương sống của AI. Chúng đặc biệt quan trọng vì khả năng mở rộng kinh tế của chúng, một điều bắt buộc phải có trong nhiều quy trình làm việc AI.

Ổ cứng Seagate có công nghệ Mozaic 3+™ — công nghệ ghi từ hỗ trợ nhiệt (HAMR) độc đáo của chúng tôi — là lựa chọn mạnh mẽ cho các ứng dụng AI nhờ mật độ diện tích, hiệu quả và lợi ích tối ưu hóa không gian. Chúng cung cấp mật độ diện tích chưa từng có là 3 TB+ cho mỗi đĩa, hiện có sẵn ở các dung lượng bắt đầu từ 30 TB và được vận chuyển theo khối lượng lớn đến các khách hàng siêu quy mô. Seagate hiện đang thử nghiệm nền tảng Mozaic, đạt được 4 TB+ và 5 TB+ cho mỗi đĩa.

So với các ổ cứng ghi từ vuông góc (PMR) thế hệ hiện tại, ổ cứng Mozaic 3+ yêu cầu công suất hoạt động ít hơn bốn lần và phát thải carbon tích hợp thấp hơn mười lần trên mỗi terabyte.

Trong khối lượng công việc AI, tính toán và lưu trữ hoạt động song song. Xử lý và bộ nhớ tập trung vào tính toán — cũng như SSD hiệu suất cao — là yếu tố thiết yếu trong các ứng dụng AI. Tương tự như vậy là các giải pháp lưu trữ dữ liệu dung lượng lớn có thể mở rộng, với ổ cứng Seagate dẫn đầu.

Xem thêm